Aquí encontrarás un fichero robots.txt especialmente preparado para mejorar la seguridad de WordPress. Te será útil si no tienes ningún robots.txt o quieres mejorar el que tienes.

El fichero robots.txt es importante por 2 motivos:

- Sirve para indicar la ubicación del fichero sitemap.xml que usa Google para obtener un listado de las páginas existentes en el sitio y que debe indexar.

- Evita que Google indexe por error ficheros con información privada y, que luego un atacante puede usar haciendo búsquedas en Google.

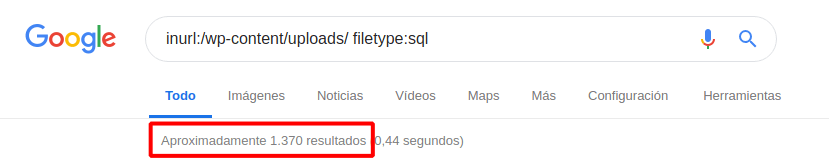

Esta técnica se llama Google Dorks. Te pongo un ejemplo de una búsqueda peligrosa que puedes hacer ahora mismo en Google y, que sirve para encontrar copias de seguridad de sitios que no tienen un fichero robots.txt que los proteja.

inurl:/wp-content/uploads/ filetype:sql

Más información sobre la importancia del robots.txt

Como puedes ver tener un fichero robots correctamente configurado es muy importante para proteger tu sitio.

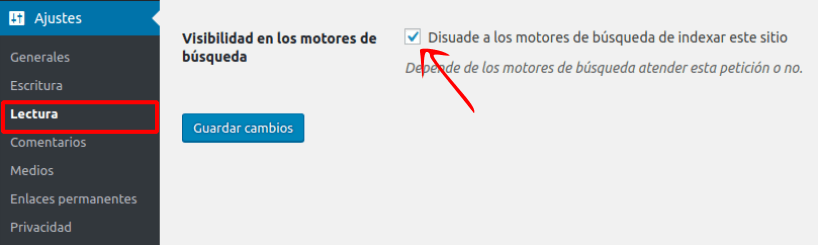

Lamentablemente, no es posible modificar el fichero robots.txt desde el escritorio de WordPress donde solo hay una opción que permite activar/desactivar la indexación en los buscadores:

Así, WordPress deja la tarea de realizar configuraciones más complejas a plugins como Yoast. Si no quieres usar Yoast u otro plugin puedes subir tú mismo un fichero robots.txt usando una cuenta FTP o el administrador de archivos.

Los desarrolladores tienen la opción de usar el filtro robots_txt para hacer modificaciones en el robots virtual de WordPress que genera dinámicamente un robots.txt en base a una programación dada.

Dónde subir el robots.txt

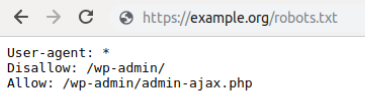

Cuando subas tu fichero robots.txt tienes que hacerlo a la raíz del sitio —si tienes un cPanel súbelo en la carpeta public_html— y para probar que funciona visita esta dirección en el navegador:

http://example.org/robots.txt

Este es el resultado si funciona bien:

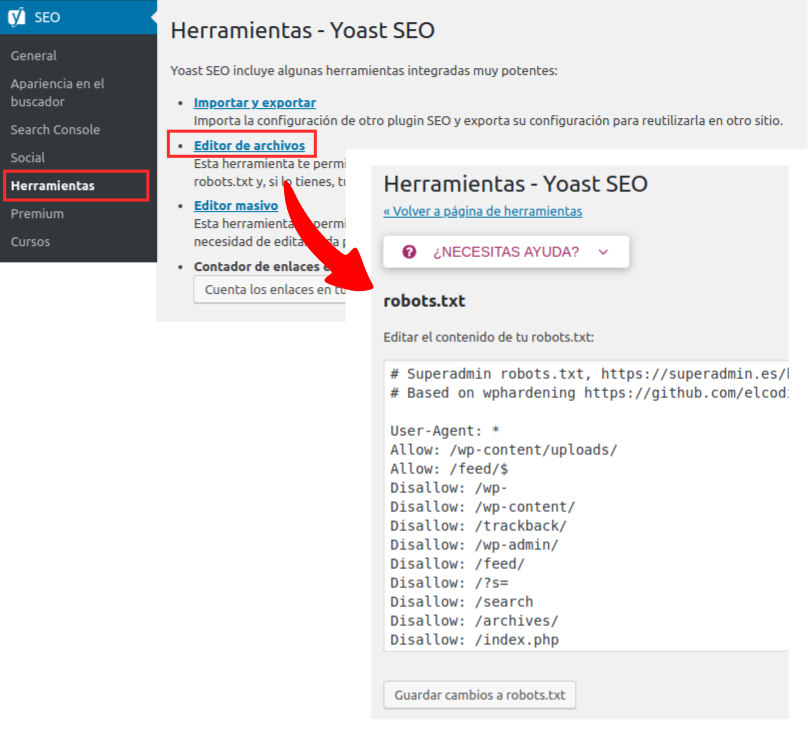

Usar Yoast para crear el robots.txt

Usando Yoast puedes crear o modificar el ficheros robots.txt de desde el escritorio de WordPress.

Encontrarás el editor clicando en el menú SEO » Herramientas » Editor de archivos. Tan solo tienes que editar el contenido y guardar los cambios.

Ejemplo robots.txt seguro para WordPress

Este robots fue diseñado para mejorar la seguridad de un WordPress y está basado en el proyecto WPHardening que es una herramienta para fortificar WordPress desde la consola de comandos.

# Based on wphardening https://github.com/elcodigok/wphardening, Copyright 2013 Daniel Maldonado

Sitemap: http://example.org/sitemap.xml

User-Agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-admin/

Disallow: /trackback/

Disallow: /?s=

Disallow: /search

Disallow: /archives/

Disallow: /index.php

Disallow: /*?

Disallow: /*.php$

Disallow: /*.inc$

Disallow: */trackback/

Disallow: /page/

Disallow: /tag/

Disallow: /category/

# No rastrear copias de seguridad

Disallow: /*.git$

Disallow: /*.sql$

Disallow: /*.tgz$

Disallow: /*.gz$

Disallow: /*.tar$

Disallow: /*.svn$

Disallow: /*.bz2$

Disallow: /*.log$

# No rastrear enlaces de WooCommerce

# https://closte.com/blog/prevent-robots-crawling-add-to-cart-links-on-woocommerce

User-agent: *

Disallow: /*add-to-cart=*

Disallow: /cart/

Disallow: /checkout/

Disallow: /my-account/

# Reglas para bots conocidos

User-agent: ia_archiver

Disallow: /

User-agent: duggmirror

Disallow: /

User-agent: noxtrumbot

Crawl-delay: 50

User-agent: msnbot

Crawl-delay: 30

User-agent: Slurp

Crawl-delay: 10

User-agent: MSIECrawler

Disallow: /

User-agent: WebCopier

Disallow: /

User-agent: HTTrack

Disallow: /

User-agent: Microsoft.URL.Control

Disallow: /

User-agent: libwww

Disallow: /

La primera línea: Sitemap: http://example.org/sitemap.xml, sirve para establecer la URL que le corresponde al fichero sitemap.xml del propio sitio. Este valor lo lee Google durante el rastreo. Es importante que pongas la URL adecuada, sobre todo si el sitio no está registrado en la

Search Console de Google.

Este ejemplo de robots.txt para WordPress esta pensado para mejorar la seguridad de tu sitio web. Es un punto de partida para empezar la personalización, desactivando otros bots o bloqueando la indexación de carpetas con contenido privado.