Los motores de búsqueda como Google usan programas, te sonará la palabra robots, para analizar el contenido de todos los sitios web y así tener datos para las consultas que se hacen en el buscador.

Existen muchísimos robots y todos analizan el contenido de tu sitio y guardan cualquier información que encuentran incluso aquella que no quieres y que luego va a aparecer en los resultados de búsqueda de Google.

Es mas, algunos robots son muy agresivos, hacen muchas peticiones al servidor que pueden llegar a bloquear haciendo que el sitio deje de funcionar. Como propietario de una web puedes indicar que robots quieres que entren y que páginas van a poder descargar.

Lo conseguirás con el fichero robots.txt que funciona del siguiente modo, cuando un robot quiere visitar un sitio web, antes descarga un fichero llamado robots.txt que es un fichero de texto que tiene instrucciones para los robots.

¿Realmente necesito el robots.txt?

No es imprescindible ya que los robots podrán acceder a tu sitio aunque no lo tengas, sin embargo es recomendable crear el fichero robots.txt por estos dos motivos:

- Podrás indicar que robot puede entrar y que páginas puede visitar.

- Es el lugar dónde los robots buscan el fichero sitemap.xml que es un fichero importante para que tu sitio aparezca en los resultados de Google. Más adelante te hablaré de este fichero.

Paso 1 - ¿Dónde colocar el fichero robots.txt?

El fichero robots.txt hay que colocarlo en el raíz del alojamiento. Si tienes un alojamiento tipo cPanel lo colocarás dentro de la carpeta public_html a la que puedes llegar desde el administrador de archivos de cPanel.

Entra al Panel de Control cPanel - Aunque la forma de entrar puede cambiar según el proveedor, lo habitual es añadir /cpanel al nombre de tu dominio http://example.org/cpanel y luego escribir un usuario y contraseña.

Pulsa en el icono Administrador de Archivos

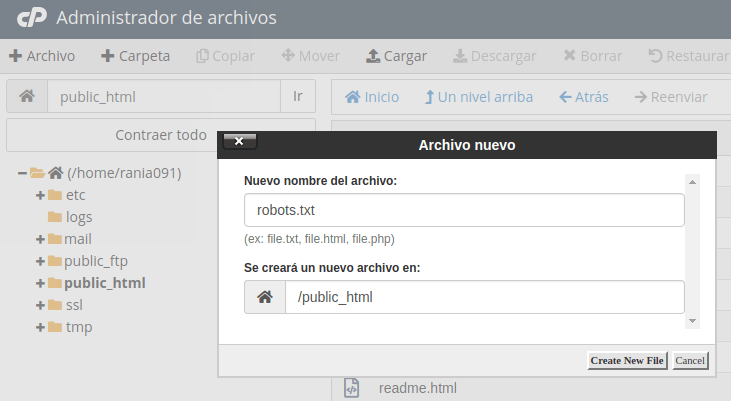

A la izquierda, en el árbol de ficheros, pulsa en la carpeta public_html para marcarla.

Pulsa en + Archivo para crear un nuevo fichero. Llamalo robots.txt y pulsa en el botón Crear nuevo archivo.

Paso 2 - Contenido de robots.txt

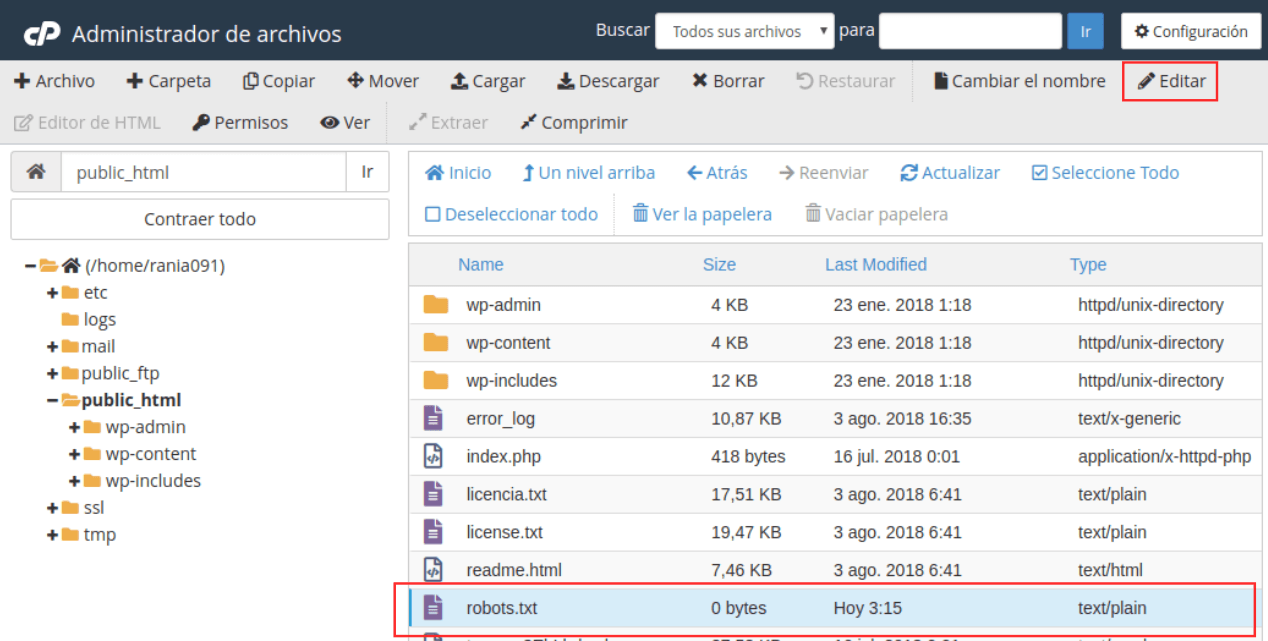

Seguimos en el administrador de archivos, pulsa sobre el fichero robots.txt y pulsa en el menú Editar.

Añade este contenido que te explico más adelante:

User-agent: *

Allow: /

La primera línea indica que todos los robos tienen acceso ya que se usa el carácter comodín (*) y en la segunda línea da permiso para entrar a todos los recursos.

- Guarda los cambios.

Para bloquear un directorio o una página

Si quieres bloquear el acceso del robot de Google a unas páginas concretas utiliza este ejemplo:

User-agent: Googlebot

Disallow: /category/

Disallow: /wp-admin/

Para bloquear ficheros por extensión

User-agent: *

Disallow: /*.zip$

Para bloquear un robot

En este ejemplo encontrarás como bloquear un robot y permitir el acceso al resto:

User-agent: *

Allow: /

User-agent: MSIECrawler

Disallow: /

Paso 3 - Comprobar que funciona

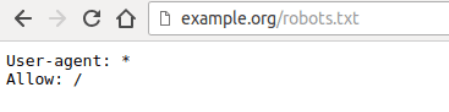

Primero tienes que probar que el fichero se ve en Internet. Utiliza un navegador, navega a la dirección de tu dominio y añade al final /robots.txt, tiene que aparecer el contenido del fichero robots.txt como aquí:

Ahora sólo falta esperar unos días a que Google actualice los resultados de búsqueda.